2020/04/23 21:30

事の発端巷で話題になっていた Rosetta@Home の方を自宅ラック内の設備の一部を使用して動かしておりましたが、当然CPUを使い切るわけですから、それなりに電力を消費することになります。Haswell世代のXeon E5 プロセッサを始めとして、100スレッド超えの計算能力を突っ込んでいました。(一時期、Rosetta@Homeにおいて国内2位の計算能力を提供していました。)しかしながら、それだけ電力使用量も増えるもので、Haswell世代のXeon E5 プロセッサを2基(計24コア48スレッド)積んだマシンを動かすと、それだけで400W近い電力を消費していました。それ以外にも多くのマシンを動かしていましたから、1.5KWh近い電力を消費していたように思います。(流石にここまで来ると、部屋が暑くなります。まだ4月でしたので、窓を開けてちょうどいい感じでした。)自宅ラック勢の中では、比較的新しいマシンが多い弊宅(当社調べ)ですが、それでも計算能力に対して電力効率が、決していいとは言えないことが気になってきます。ここまで来ると、より良いものが欲しくなるのが人の性。AMD EPYC プロセッサ、中でもZen2アーキテクチャを採用したRomeに目をつけました。 構成を考えるまず、筐体(ケース)ですが、弊宅の36Uサイズの19インチサーバーラックへインストールするため、2Uサイズのラックケースを選択しました。そうすると、高さが80mm程度を低いため、市販品のCPUクーラーは入らなくなります。当然、サーバー向けプロセッサですから、2Uサイズの空冷CPUクーラーも存在します。しかしながら、TDPが150Wを超えるようなプロセッサを2Uサイズに収まるような小さな空冷CPUクーラーで冷却したところで、冷却能力を高めるためにファンが高速回転しうるさくなるか、ファンの回転数を落としたために冷却不足になるなど、冷却や音の問題が出てきます。弊宅はワンルームですから寝室を兼ねていますし、極力音は小さくしたいものです。そこで、思い切って水冷にしてみることにしました。クーラントによって熱を移動させ、2Uサイズの空冷クーラーよりは大きな断面積を確保したラジエータによって冷却するのです。本格水冷自体始めてで、どの程度冷却できるか、静音性等は未知数でしたが、チャレンジしてみることとしました。

2020/04/08 15:00

知り合いが、増設したHDDを認識しない現象に見舞われ、トラブルシューティングしたのでそのログです。軽く調査を行ったところ、Seagate製のHDDにおいて稀に発生するようです。原因調査中、思ったように情報にたどり着けなかったので、記しておきます。予め申しておきますが、本記事はSeageteさんに対する批判等ではございません。(解決方法が知りたい人は、この記事の下部へ)Windows10PCにHDDを増設するも認識しない!?BIOS上には増設したHDDが表示され、Windows10上のデバイスマネージャー上でも、増設したHDDは認識されていました。しかしながら、増設したHDDを使用するにはMBRないしはGPTのパーティションテーブルを作成する必要があります。通常、Windows10ではこれらの操作はディスクの管理から行うこととなります。しかし、肝心のディスクの管理には当該HDDは表示されていませんでした。 ちなみに、CrystalDiskInfoでは認識し、S.M.A.R.T.情報を読み取ることができる状態でした。これは、接続ケーブルの不良やマザーボードの故障ではないことを意味します。新品なのにHDD上になんか残っている…?調べてゆくと、Windows10上で記憶域プールとして認識されたものは、ディスクの管理に表示されないことがわかります。今回の症状に合致します。(そのような設定を行ったかどうかは別として…) 解決方法…?そこで、Windows10上から記憶域プールの設定を確認します。(設定へのたどり着き方は各自調べてください。 設定 から行く方法と、コントロールパネルから行く方法があります。)本件の場合、他人のPCだったのでスクリーンショットがありませんがディスクの管理に表示されないディスクが、記憶域プールとして使用されていました。すでに記憶域プールを利用している方は、操作を行うディスクを間違えないように注意しながら、この記憶域プールを削除します。 本件においては、以上の操作を行うことで、ディスクの管理上に表示されるようになりました。 *当該操作等を行ったことによるデータの喪失その他について、当記事の筆者は何ら責任を負いません。原因は?本症状は稀に発生することが多いようで、大抵の場合返品交換をしてもらうことで解決しているようです。また、その殆どがSeagat

2020/01/31 14:00

さておよそ半年前、MikroTik社のCRS326-24S+2Q+RMを購入した記事を書きましたが、40GbEのテストは後でやると書きました。ようやくそのテストを実施する(気になる)ことができたので、その結果を記していきたいと思います。環境本当はLinux機でテストしたかったのですが、ぱっと使えるマシンがWindowsしかなかったので、諦めてそちらでテストを行いました。マシン2 (HPE DL380 Gen9)なお、Desktop機においてはNICが冷却できずに燃えそうだったので、サーキュレータの風をぶち当てて強制冷却することにしました。PC1 --- CRS326-24S+2Q+RM --- PC2こんな構成でテストを行いました。なお、IPアドレスについては別途DHCPサーバからの配布としました。iperf3 with MTU 1500$ ./iperf3.exe -c 192.168.5.111Connecting to host 192.168.5.111, port 5201[ 4] local 192.168.5.110 port 51729 connected to 192.168.5.111 port 5201[ ID] Interval Transfer Bandwidth[ 4] 0.00-1.00 sec 1.01 GBytes 8.71 Gbits/sec[ 4] 1.00-2.00 sec 963 MBytes 8.07 Gbits/sec[ 4] 2.00-3.00 sec 965 MBytes 8.09 Gbits/sec[ 4] 3.00-4.00 sec 1.06 GBytes 9.07 Gbits/sec[ 4] 4.00-5.00 sec 1.14 GBytes 9.76 Gbits/sec[ 4] 5.00-6.00 sec 1.13 GBytes 9.74 Gbits/sec[ 4] 6.00-7.00 sec 1.06 GBytes 9.10 Gbits/sec[ 4] 7.00-8.00 sec 1.10 GBytes 9.41 Gbits/sec[ 4] 8.00-9.0

2019/12/31 23:30

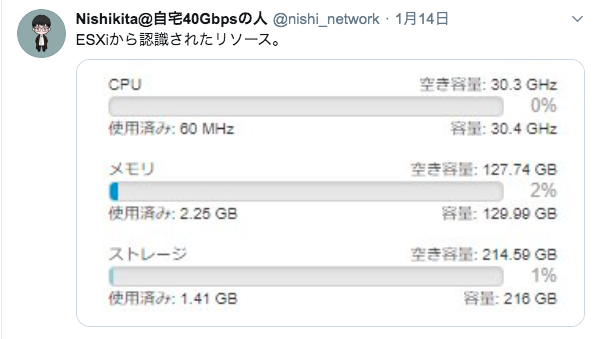

さて、もう2019年も終わろうとしている大晦日、今年もあと2時間ちょっとで終わる今2019年の振り返りをして見ようと思います。読んでもなんの特にもならないので、今すぐブラウザバックしてテレビでも見たほうがいいんじゃないでしょうか。途中なんかどうでもいいという人は、この記事の一番下にまとめてあります。 1月自分でも覚えてないんで、自身のツイートを漁って見てたのですが、何してんだこいつってなりましたね。1月真ん中らへん、VMWare ESXiを触ってみてたみたいですね。 自分の記憶にあるのは、とりあえず1Uサーバーにインストールして触ってみたところまでです。結局その後Proxmoxを採用しましたので…。 そして、Twitterでたちまち話題となった「例のグラボ」こと、マイニング向けのRX470 8GB。こいつの映像出力端子を有効化して遊んだりしてました。 1005という規格の1mm x 0.5mmサイズのパーツを付ける作業を手作業でしてみたくて、買った感じですね。その後このグラボは部品箱へと入ってゆきましたとさ。 そして、人生初の新品サーバー、FujitsuのPrimergy RX1330 M1を購入した月でもありました。3万ぐらいで買えたのでお得だったなと。2月先程紹介したサーバー、やっとここで開封したらしいです。何やってんだ。 そして、ラックに入れてたらしいですね。このときのラックはまだ24Uでした。(ということは後ほど何かが起こります。) そして、2月中旬頃から休暇期間に入ったはずなのに、ツイッターばかりしていて進捗が見つかりませんでした。(?)この時期に、今の構成(iSCSIを用いたストレージシステム)の基礎ができたように思います。 3月どうやらいい加減ネットワークをちゃんとやろうと思って、ルーティング周りの勉強(と言っても実際に設定して動作させるところまで)をしていたように思います。そして過去の自分は「OSPFとBGP完全に理解した」とか言っていますね。ホントかな?????? そして、知り合い宅のとの間にVPNを張ってBGPやる作業をした記憶があります。 また、それまで宅内のサーバーはHPのProLiant DL360 G7を3台+αとして運用してましたが、この時期からGen8へのリプレイスを始めました。Gen8がそれなりにお安く買えるよう

2019/09/04 19:00

40GbE対応スイッチMikroTikから発売された、世界最安の40GbE対応スイッチとも言える CRS326-24S+2Q+RMを手に入れたので紹介します。スペック本製品の目玉は、40GbEに対応したことでしょうか。40GbE対応のQSFP+ポートを2つ搭載しており、ToRのスイッチとしての利用を想定していると言えそうです。また、MikroTikはこの他に、40GbE QSFP+をアップリンクとした1GbEスイッチを発表するなどしており、今後の40GbE製品の展開に期待が持てそうです。さらに、MikroTikの製品は、安いものも含めてPSUが冗長化されているのが特徴だと言えます。本製品も例にもれず、PSUは冗長化されています。購入EuroDKより、384ドルで購入しました。安い…この記事を書いている時点ではすでに売り切れとなっているようです。 外観箱はCloud Router Switchのいつもの箱です。中には簡単なマニュアル。 本体。MikroTikCloud Router Switch CRS326-24S+2Q+RMポートポートは左からSFP+ 1から24 QSFP+ 1から2 となっています。ポートの番付が下から上に1,2となっている点、間違えないように気をつけたほうがいい点ですね。背面背面にはPSUが2つ、Fanが3つ付いているようです。CRS317-1G-16S+RM も所持していますが、背面のヒートシンクがなくなった点、スリムになったように感じます。Fanはうるさい?Fanのうるささは結構気にする人が多いと思います。これについては、最新のRouterOS Stable 6.45.5 にすることで、低温時はFanは回転せず、温度が上がってくるとFanが回るようになります。個人的にはこれでかなり静かになりました。動作40GbEについては、まだ対向が届いていないので、届き次第レビューしたいと思います。本当に性能がでるの?MikroTikが公開しているブロックダイアグラムを見る感じ、L2レベルであればしっかりとワイヤースピードが出そうです。実際に、CRS317-1G-16S+RMではワイヤースピードが出ています。 利用用途ラック内ではToRのスイッチとして、CRS317-1G-16S+RMが稼働中です。 2つ合わすと10GbE SFP+ Portが

2019/08/25 23:00

そういえば、自宅環境の紹介をしていなかったなと思い、急遽書きました。サーバラックサーバラックの様子をどん。上からまだラッキングしてないサーバがは横に転がってます。ちなみにLANケーブルは半分ぐらい自作です。 ストレージネットワークは10GbEで構成。ネットワーク構成はこんな感じ。知り合いとVPNを張っていて、その経路交換をBGPで行っています。スペックコアになってるProxmoxサーバのスペックはサービスホストしているものを軽く紹介。監視環境とかサービスの死活監視をZabbixにて行い、リソースの可視化をGrafanaで行っています。個人でそこまでする必要があるのかは分かりませんけどね。まとめ何も知らないところ、サブネットマスクもわからないところから約1年、個人でここまでできたのは我ながら驚いています。やはり、自分が好きに触れる物理環境があれば、何でもまず”試してみる”ことができるので良いですね。その過程で色々なノウハウも得ることができました。

2019/08/08 10:54

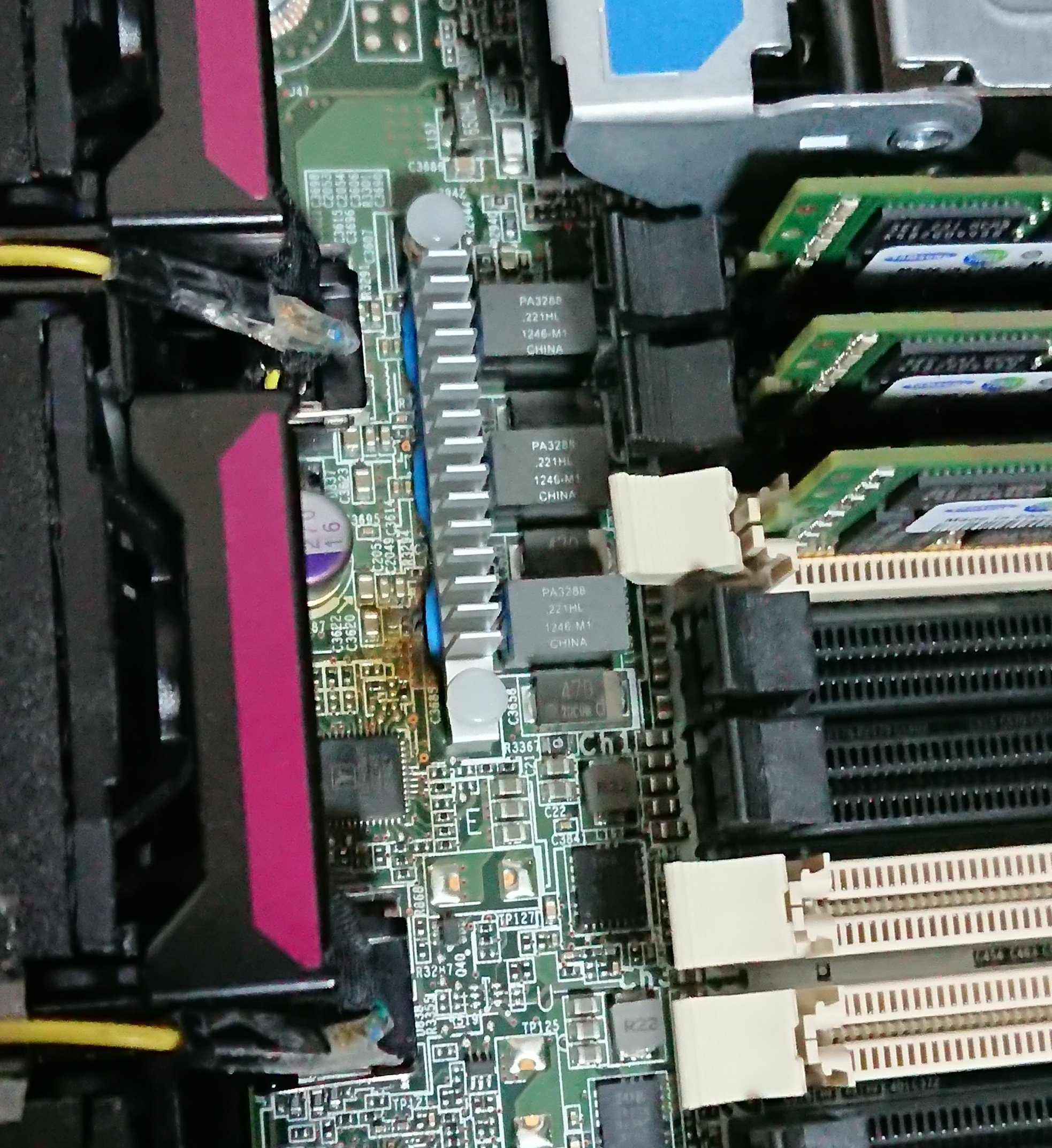

突然ですがサーバが燃えました。中央付近、メモリのVRM回路と思われる部分が焼損していることがおわかりいただけると思います。状況とある日の夜22時ごろ、突然室内の音が変わった気がして、サーバを確認すると、うち1台が停止しており、FaultのLEDが点灯しておりました。HPのサーバでしたので、iLO4からログを確認すると、電源系のエラーが出ておりました。(スクショ忘れた)PSU以上かと思った主は、PSU#1が接続された状態でPSU#2を接続してからPSU#1を交換するという方法を取り、サーバの電源を喪失することなくPSUの交換を行いました。しかしながら、電源ボタンを押しても電源が入ることはなく、電源ケーブルを接続し直すことにしました。電源ケーブルの再接続を終え、電源ボタンを押すと…燃えたはい、燃えました。といっても目視で確認できていないですが、花火に火をつけたような音やスパークの飛ぶ音が1.5秒ほど続き、一瞬にして室内には半導体の燃える匂いでいっぱいに。ヒートシンクがマザーボードを外さずに撤去することができなかったので直視できていませんが、半導体チップが溶けてぐちゃぐちゃになっていました。チップ、半田ゴテとか当てても溶けませんから、相当の温度になっていたのでしょう。原因は?完全な原因究明には至っておりません。考えられることとしては、前日に行ったUPSのマウント作業の際、レールのかみ合わせが悪く、スライドさせるたびにカンナで削ったような金属片が散乱してしまっていましたので、それを運悪くサーバが吸い込んでショートした、ということぐらいでしょうか。 そして、ショートを検知して電源が落ちたものの、主が一度電源を喪失させたためにエラーのステートが消え、エラーをディテクトする前にサーバの電源が入ってしまって燃えた、というところでしょうか。だとすると、勝手に燃えることは無いはずです。おそらく、燃える前に止まるでしょうから。被害?まず、このサーバ、コアサーバだったのですが当然死亡しました。(というか燃えてから電源入れてない)稼働1ヶ月ほどでしたので、かなりダメージが大きいものです。あと、燃えたVRM回路から電源供給を受けていたと思われるメモリが死亡しておりました。これは廃棄。 まとめ?5万ちょっとぐらいの被害は出ましたが、家が燃えなくてよかったです。自宅でサーバ類を運用している方、

2019/07/19 12:10

計測環境計測結果HDDとは思えない速度が出ているようです。おそらくストレージサーバ側でメモリキャッシュがきいているからですかね。

2019/06/28 13:00

Interop Tokyo 2019 に行ってきましたので、軽くレポートとしてまとめます。技術的な内容は一切無いのであしからず。Interop TokyoとはInterop Tokyo(インターロプ・とうきょう)とは、首都圏における、ネットワーク・インフラストラクチャー技術、製品、またそれらを用いたソリューションサービスについての展示会である。wikiよりまぁあれです。最新のネットワーク機器等が展示される展示会です。実際に機器を間近で見ることができます。 後は、ShowNetなどで行われている相互接続テストの様子や、ラックに入れられた機器が見どころの一つではあると思います。行くことになったきっかけ今回のInterop Tokyo 2019 への参加は、普段からお世話になっている教員からの提案によるものです。技術系の展示会などはどうしても関東圏での開催が多く、関西圏の学生が参加することはどうしても難しいのが実情でした。そんな中、サイオステクノロジー株式会社さんは、特に地方の技術系大学生に対して都市圏でのイベント参加を支援するプロジェクトを始めておられ、教員からの推薦もあって今回、交通費と宿泊費を支援していただけることになりました。 気になる人は支援プログラムのページをご覧ください。1日目昔、東京に住んでおりましたので、多少の土地勘はある状態で東京へ向かいました。あまりInterop自体に関係のないことも書いておりますが、久々の東京でしたので地方学生の戯言だと思って見ていただけると幸いです。東海道新幹線・京都駅構内で見つけたYAMAHAさんの広告です。YAMAHAさんの広告は初めてみましたので、思わず撮ってしまいました。せっかくですので、品川駅にて下車しサイオスさんの中の人に食事へ連れて行ってもらいました。その中で、今自身が取り組んでいることについてや、最近の学生の動向、後は雑談で、1時間ほどお話をさせていただきました。もちろん、就活とかは全く関係ありませんので、気軽にお話をさせていただくことができました。その後は、知り合いと会ったり、プチ東京観光を満喫しました。幕張へ山手線で東京駅へと向かい、京葉線へ。東京駅から京葉線ホームへの距離が長くて焦りました。 京葉線へ乗車し、快速で30分程で海浜幕張駅へと。1日目は、海浜幕張駅付近のホテルへ滞在し、翌13日にInte

2019/06/17 13:00

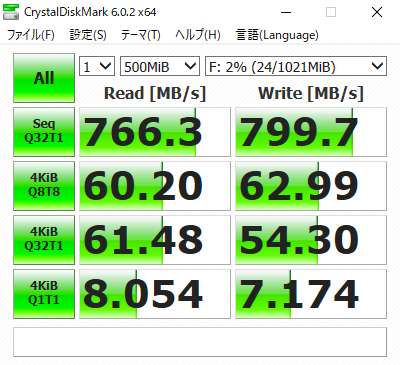

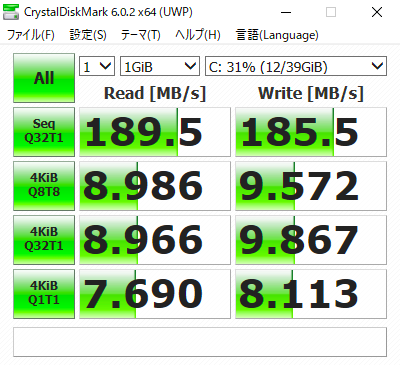

環境ProxmoxNetwork症状ProxmoxからFreeNASへNFSで接続し、Windowsを入れる。このとき、Proxmox側のディスクドライブはIDE0この状態でCrystalDiskMarkをかけた結果が以下HDDはWD REDだし、RAID-Zとはいえ、Read/Writeともにほぼ同じ速度で頭打ちなのはおかしい。FreeNAS側でも、CPUやメモリが張り付く様子もなく、他のNFSで同じように測定されている方の結果からも、FreeNAS側の問題ではないと判断。作業結論から言うと、Proxmox上のWindowsのディスクを、IDE0からSCSI0にした。この辺は、VirtIOのドライバを入れたりしないといけないので、別途作業が必要。これがちょっと面倒である。 結果Proxmox上のWindowsのディスクをSCSI0にして、再度CrystalDiskMarkで計測した結果が以下である。 めちゃめちゃ早くなった。Readに関しては、CrystalDiskMarkの性質上、テスト前に書き込んだテスト用データがFreeNASのNFSボリューム上のキャッシュにあり、キャッシュから読み出したものだと思われる。しかしながら、Writeに関しては、ディスクから直接読み込んでいると思われる数値が出ている。結果として大幅な速度向上に成功した。 余談これはあくまでも推察なので、事実と異なるかもしれないが、CrystalDiskMarkがディスクのベンチマークを行う際、以下の順序で実行されているように思う。この手順だと、テストデータを2回書き込む必要があると考えられる。以下の処理順序にすれば、効率よくベンチマークが行えないだろうか? この順序だと、書き込みや読み込み処理が1度で済むと考えられる。当然、何か理由があって、現状の処理順序になっていると考えられるが、それが自身には分からないので、誰かご教示願いたい。