事の発端

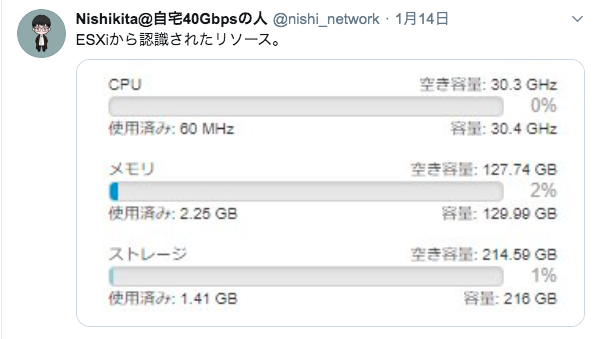

巷で話題になっていた Rosetta@Home の方を自宅ラック内の設備の一部を使用して動かしておりましたが、当然CPUを使い切るわけですから、それなりに電力を消費することになります。

Haswell世代のXeon E5 プロセッサを始めとして、100スレッド超えの計算能力を突っ込んでいました。

(一時期、Rosetta@Homeにおいて国内2位の計算能力を提供していました。)

しかしながら、それだけ電力使用量も増えるもので、Haswell世代のXeon E5 プロセッサを2基(計24コア48スレッド)積んだマシンを動かすと、それだけで400W近い電力を消費していました。

それ以外にも多くのマシンを動かしていましたから、1.5KWh近い電力を消費していたように思います。

(流石にここまで来ると、部屋が暑くなります。まだ4月でしたので、窓を開けてちょうどいい感じでした。)

自宅ラック勢の中では、比較的新しいマシンが多い弊宅(当社調べ)ですが、それでも計算能力に対して電力効率が、決していいとは言えないことが気になってきます。

ここまで来ると、より良いものが欲しくなるのが人の性。

AMD EPYC プロセッサ、中でもZen2アーキテクチャを採用したRomeに目をつけました。

構成を考える

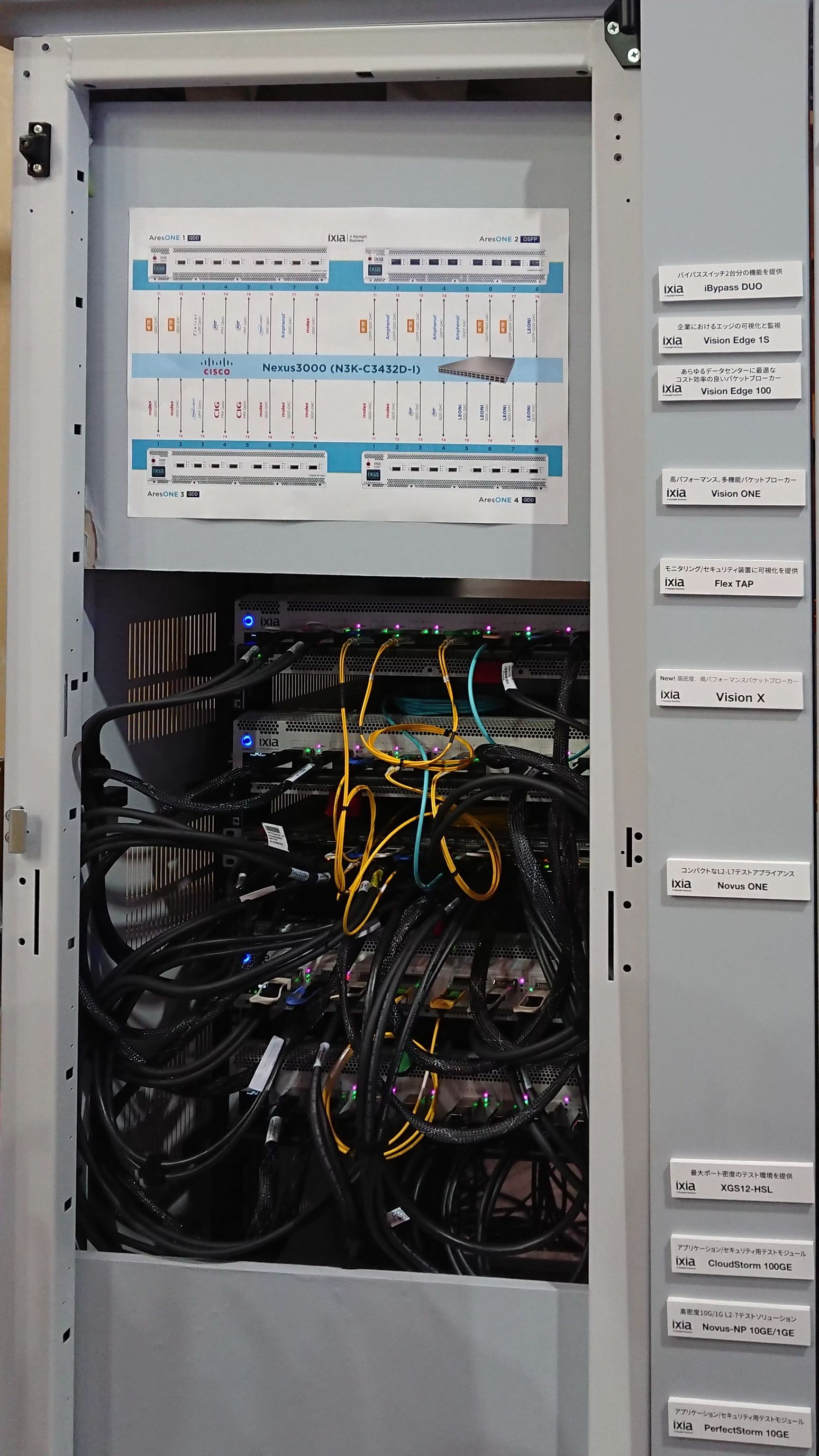

まず、筐体(ケース)ですが、弊宅の36Uサイズの19インチサーバーラックへインストールするため、2Uサイズのラックケースを選択しました。

そうすると、高さが80mm程度を低いため、市販品のCPUクーラーは入らなくなります。

当然、サーバー向けプロセッサですから、2Uサイズの空冷CPUクーラーも存在します。

しかしながら、TDPが150Wを超えるようなプロセッサを2Uサイズに収まるような小さな空冷CPUクーラーで冷却したところで、冷却能力を高めるためにファンが高速回転しうるさくなるか、ファンの回転数を落としたために冷却不足になるなど、冷却や音の問題が出てきます。

弊宅はワンルームですから寝室を兼ねていますし、極力音は小さくしたいものです。

そこで、思い切って水冷にしてみることにしました。

クーラントによって熱を移動させ、2Uサイズの空冷クーラーよりは大きな断面積を確保したラジエータによって冷却するのです。

本格水冷自体始めてで、どの程度冷却できるか、静音性等は未知数でしたが、チャレンジしてみることとしました。

懸念事項

水冷にするということは、当然液体を用いますから、空冷CPUクーラーに比べて、より頻度の高い定期的なメンテナンスが必要となります。

今回は、そのリスクを頭の片隅に置いた上で、本格水冷を採用することとしました。

パーツ

| 詳細 | |

|---|---|

| CPU | AMD EPYC 7452 32Core Processor |

| M/B | Supermicro H11SSL-i (要Rev2.0) |

| Memory | DDR4 ECC Registered 16GB x8 計128GB |

| PSU | 80PLUS GOLD 定格500W ATX電源 |

| Radiator | Alphacool NexXxoS XT45 Full Copper 80mm (240mm length) |

| WaterBlock | TR40用ブロック |

M/B(マザーボード)については、Supermicro製のものを選択しました。

しかしながら、Rome世代のEPYC 7002シリーズには、rev2.0以降のものでないと対応しないとのことだったので、rev2.0以降のものを入手しています。

(どうもフラッシュチップの容量の関係みたいです)

Memoryについては、別マシンで使用予定で入手したものの使わなくなったものがあったので、それを利用することとしました。

ラジエータについても、2Uサイズに収まるものを選択しています。

また、EPYC プロセッサのソケットはSP3ですが、形状はTR4と同様です。(ピン互換性はありません)

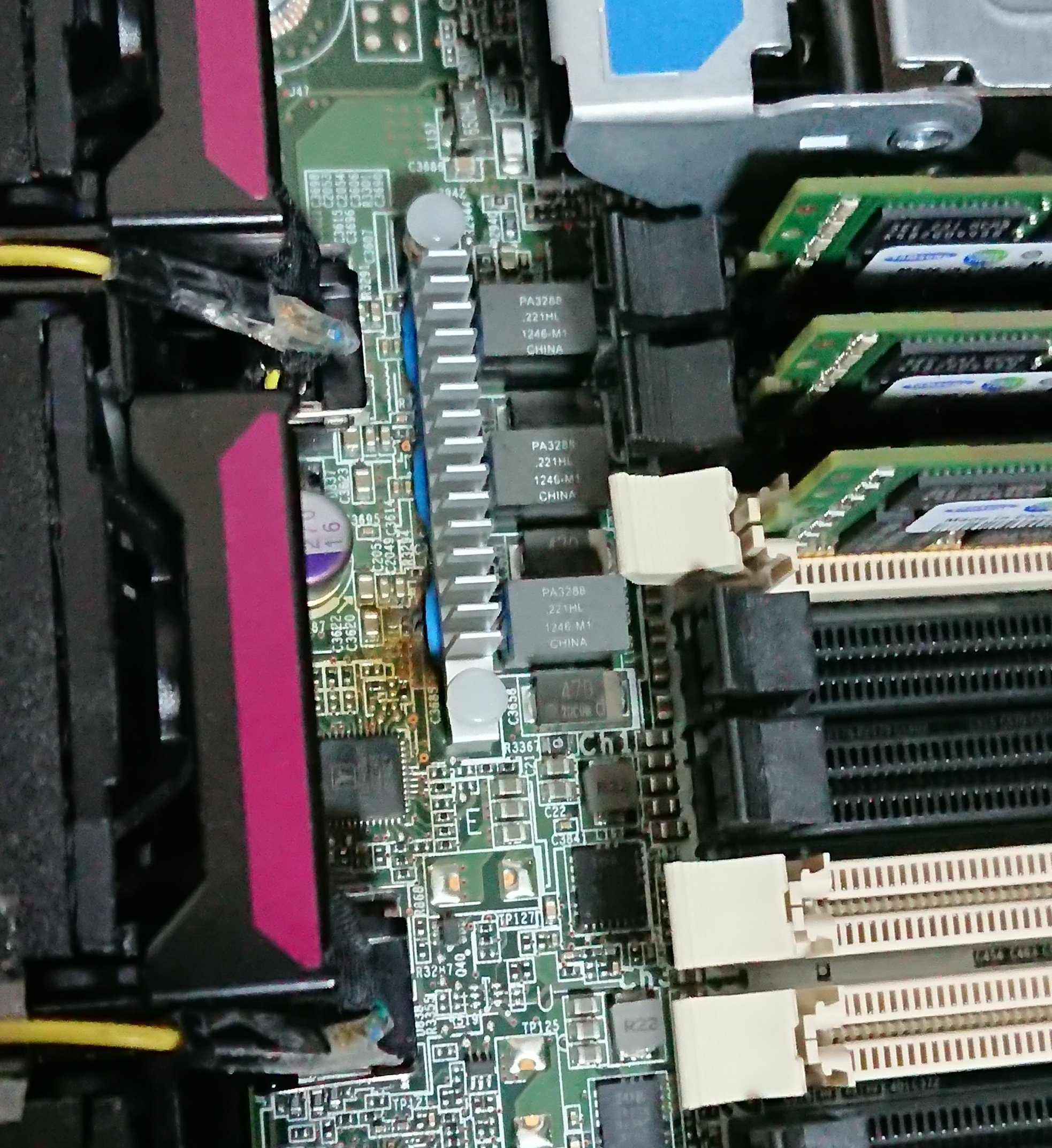

組んでみた

まずはCPU、やはり大きいですね。

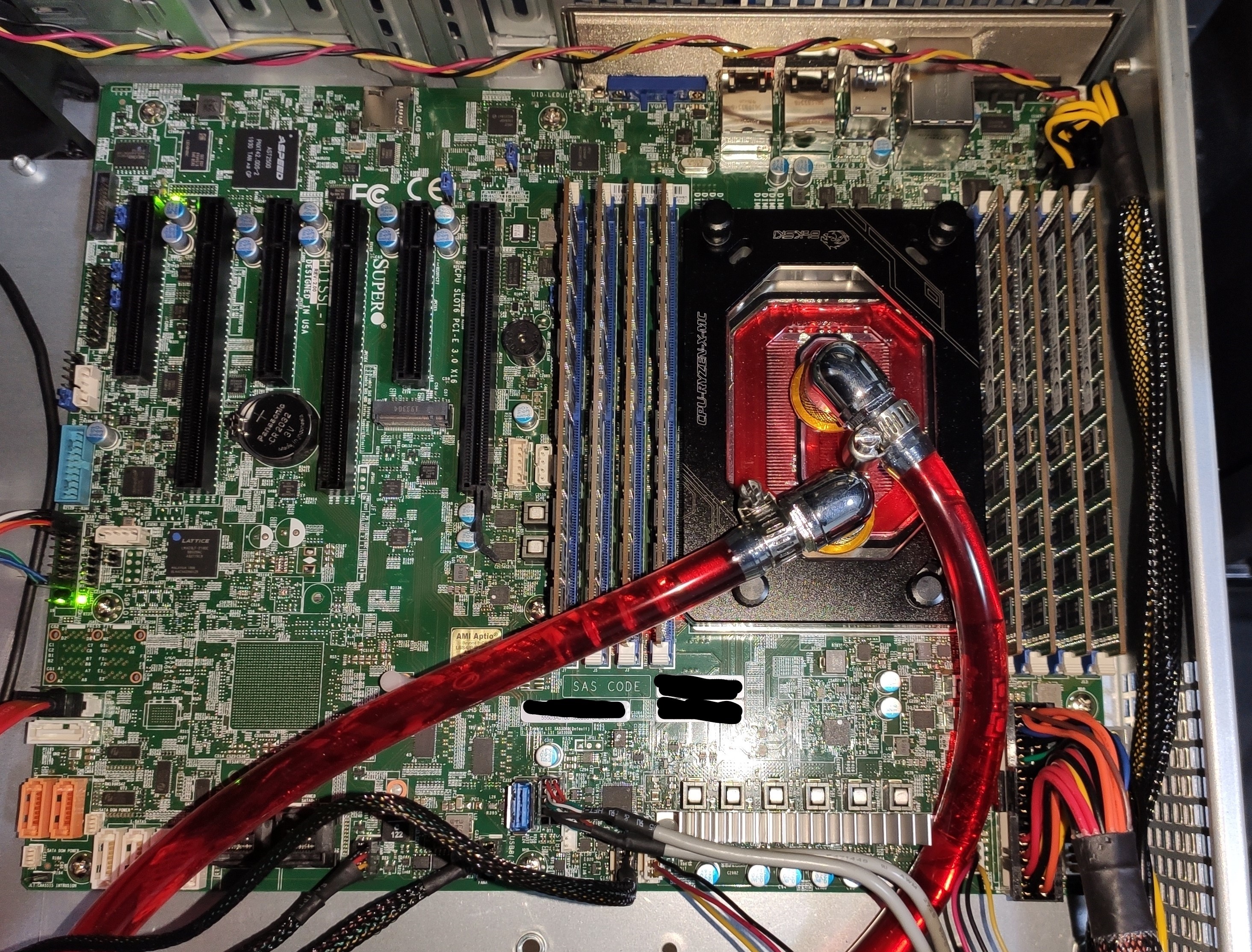

そして、組み込んだ図。

クーラントの色は、なんとなく赤にしてあります。

(リークテストの際に、漏れた場合ティッシュが着色されてわかりやすいかなぁと)

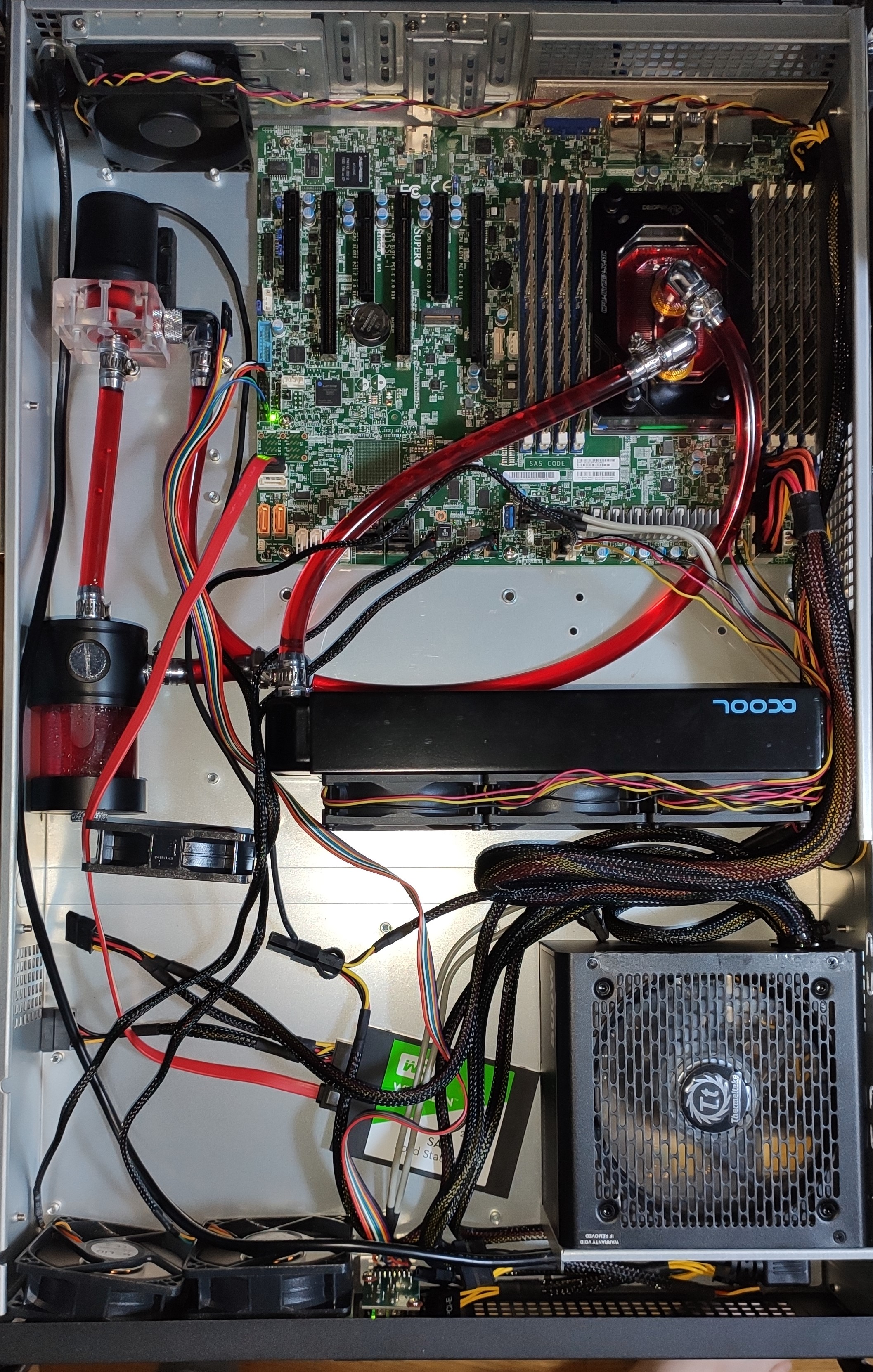

全体像は以下のようになりました。

下の方に転がっているWDのSSDはテスト用の物です。

また、ファンなども仮設置のものが多くて、全体的に散らかっていますがご容赦を。

特に漏れることもなく、組むことができています。

また、動作にも問題ありませんでした。

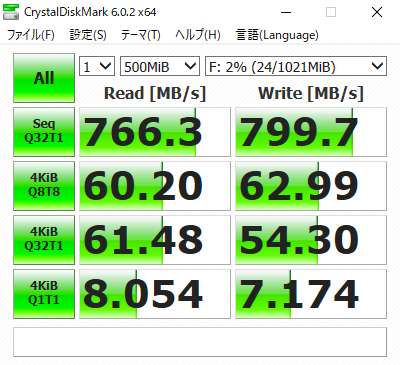

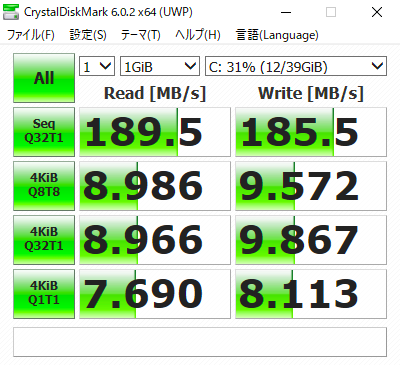

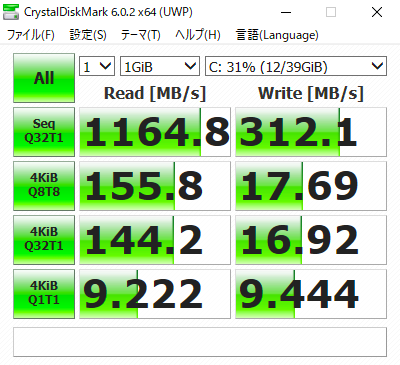

パフォーマンスは?水冷の効果は?

各ベンチマークや、水冷の効果の考察については、後日投稿する別記事にて記したいと思います。